Gradient descent

Gradient descent (בתרגום מילולי: מורד הגרדיאנט) היא שיטת אופטימיזציה איטרטיבית מסדר ראשון למציאת מינימום מקומי של פונקציה. בשיטה זו, נעשה צעד נגדי לגרדיאנט ביחס לנקודה הנוכחית.

לעומת זאת, אם נעשה צעדים בכיוון של הגרדיאנט נמצא את המקסימום המקומי של הפונקציה (אלגוריתם זה נקרא Gradient ascent, בתרגום מילולי: מעלה הגרדיאנט).

מבוא אינטואיטיבי

עריכההשיטה עובדת על שדה סקלרי של נתונים. שדה סקלרי הוא פונקציה המתאימה לכל נקודה במרחב ערך מספרי. המרחב יכול להיות בעל מספר רב של ממדים. דוגמה לשדה סקלרי בשני ממדים הוא מפה טופוגרפית, בה לכל נקודה על המפה הדו-ממדית משויך הגובה מעל פני הים.

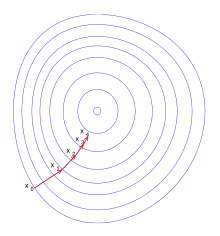

לפי השיטה משתמשים בגרדיאנט, שהוא כלי מתמטי וקטורי, כלומר בעל כיוון, המאפשר למצוא את הכיוון אליו הנגזרת מקסימלית דהיינו הכיוון בו נמצא השינוי הדרסטי ביותר בין הנתונים סביב נקודה מסוימת. במפה הטופוגרפית יהווה הגרדיאנט הכיוון בו השיפוע מקסימלי, והאלגוריתם אמור להתכנס למינימום מקומי של השדה הסקלרי .

השיטה עובדת כך שבכל שלב של ההפעלה היא מתקדמת לכיוון הפוך לגרדיאנט (כיוון שהגרדיאנט מראה את השיפוע כלפי מעלה) כך שבכל שלב יש התקדמות נגד השיפוע המקסימלי עד שמגיעים לנקודה מספיק נמוכה המוגדרת בתנאי העצירה. דבר זה דומה לאדם העומד בנקודה על המפה הטופוגרפית אך ישנו ערפל סמיך אשר עוצר בעדו. לכן באפשרותו לבדוק רק את סביבתו הקרובה. הכיוון שבו הוא יורד יהיה הכיוון בו המדרון תלול ביותר.

תיאור מתמטי

עריכהGradient descent מבוססת על ההבחנה שאם פונקציה מרובת משתנים מוגדרת ודיפרנציאבילית בסמוך לנקודה , אז יורדת בצורה התלולה ביותר כשהולכים מ בכיוון נגדי לגרדיאנט של ב- , . מכאן שאם

עבור קטן דיו, אז . במילים אחרות, הביטוי מוחסר מ- כיוון שרוצים לזוז נגד כיוון הגרדיאנט, מטה לכיוון המינימום. בהתבסס על הבחנה זו, ניתן לנחש נקודה ראשונית כנקודת מינימום של , ולקבל את הסדרה כך ש:

שבהתבסס על ההבחנה:

הסדרה יכולה להתכנס לנקודת המינימום המבוקשת. גודל הצעד יכול להשתנות בכל איטרציה. יחד עם הנחות מסוימות על הפונקציה (לדוגמה, קמורה ו ליפשיצית) ובחירות מתאימות של (למשל באמצעות line search שמקיים את תנאי וולף או שיטת ברזילאי-בורווין להלן),

מתכנסת הסדרה למינימום מקומי. כאשר הפונקציה היא קמורה, ניתן להשתמש ב-gradient descent למציאת פתרון גלובלי.

ב-1964 הציג בוריס תאודורוביץ' פוליאק הרחבה לשיטה שנקראת שיטת המומנטום אשר משפרת את קצב ההתכנסות.[1] ב-1983 הציג יורי נסטרוב את שיטת הגרדיאנט המואץ (Nesterov’s Accelerated Gradient ולעיתים בקיצור NAG), שיכולה להשיג קצב התכנסות טוב יותר.[2] גרסה נוספת של Gradient descent מבוססת על הערכה סטוכסטית של הגרדיאנט וידועה כ-Stochastic gradient descent.

אלגוריתם

עריכהלהלן קוד פייתון של האלגוריתם gradient descent:

# x0 - initial guess

# df - gradient of function

def gradient_descent(x0, df):

cur_x = x0 # The algorithm starts at x0

gamma = 0.01 # step size multiplier

precision = 0.00001

previous_step_size = cur_x

while previous_step_size > precision:

prev_x = cur_x

cur_x += -gamma * df(prev_x)

previous_step_size = abs(cur_x - prev_x)

return cur_x

קישורים חיצוניים

עריכההערות שוליים

עריכה- ^ B. T. Polyak, “Some methods of speeding up the convergence of iteration methods”, Zh. Vychisl. Mat. Mat. Fiz., 4:5 (1964), 791–803; U.S.S.R. Comput. Math. Math. Phys., 4:5 (1964), 1–17, www.mathnet.ru

- ^ YU. E. NESTEROV, A method of solving a convex programming problem with convergence rate O(1/k^2), Soviet Mathematics Doklady, 27, 1983